OpenAI a lancé la famille o3 pour résoudre un enjeu simple mais majeur : certaines questions exigent plus qu’une réponse rapide — elles demandent une vraie réflexion. Annoncé fin 2024, o3 introduit des mécanismes qui poussent le modèle à décomposer, vérifier et corriger son raisonnement avant d’afficher une réponse, ce qui change profondément la manière dont on peut s’appuyer sur une IA pour des tâches complexes.

Qu’est-ce que o3 et pourquoi c’est différent ?

o3 est un modèle « raisonneur » : au lieu de produire directement une sortie, il génère et évalue des étapes intermédiaires (une chaîne de pensée interne) pour élaborer une réponse plus robuste. Ce principe, formalisé par OpenAI sous le nom de deliberative alignment, oblige le modèle à réfléchir explicitement à des règles de sécurité et à la qualité de son raisonnement avant restitution. Le résultat : des réponses souvent plus cohérentes, plus justifiables et moins sujettes aux « hallucinations » typiques des LLM mal contrôlés.

Penser avec des images : une innovation multimodale

Une avancée notable d’o3 est sa capacité à intégrer les images directement dans sa chaîne de raisonnement. Autrement dit, le modèle ne se contente pas de « voir » une image : il pense avec elle, en combinant éléments visuels et raisonnement textuel pour résoudre des problèmes qui mêlent texte et image (analyse de graphiques, diagnostic d’un schéma technique, etc.). Cette fusion ouvre des cas d’usage nouveaux pour la recherche, l’ingénierie et l’éducation.

o3-mini : la version rapide, économique et largement disponible

OpenAI a parallèlement publié o3-mini, une déclinaison plus légère et optimisée pour le rapport coût/performance. Lancé en preview puis proposé dans ChatGPT et via l’API, o3-mini vise à offrir la plupart des bénéfices du raisonnement d’o3 avec une latence plus faible et un coût réduit — et, pour la première fois sur cette famille, une version utilisable par des utilisateurs gratuits sous certaines limites. Des tests et communiqués parlent d’un gain de vitesse notable par rapport aux générations o1-mini précédentes.

Comparaison — o3 vs o1

Voici un ajout clair et pratique à intégrer dans votre article : un comparatif synthétique entre les deux familles de modèles o3 et o1, basé sur les annonces officielles et les évaluations publiques.

Résumé rapide

-

o1 a été la première famille « raisonneuse » d’OpenAI, lancée en 2024 pour améliorer la qualité des réponses sur des tâches multi-étapes (maths, code, logique).

-

o3 a été présenté comme le successeur, avec un focus renforcé sur la délibération interne (deliberative alignment) et une précision accrue sur les tâches complexes ; son déploiement (o3 et o3-mini) vise à remplacer/compléter o1 dans les scénarios exigeants.

Tableau comparatif (points clés)

| Critère | o1 | o3 |

|---|---|---|

| But principal | Première génération « raisonneuse » (chaînes de pensée) pour tâches complexes. | Renforcement de la délibération (deliberative alignment) : réflexion interne + sécurité. |

| Méthode d’alignement | Chaînes de pensée / RLHF. | Deliberative alignment (évaluation interne des règles de sécurité avant réponse). |

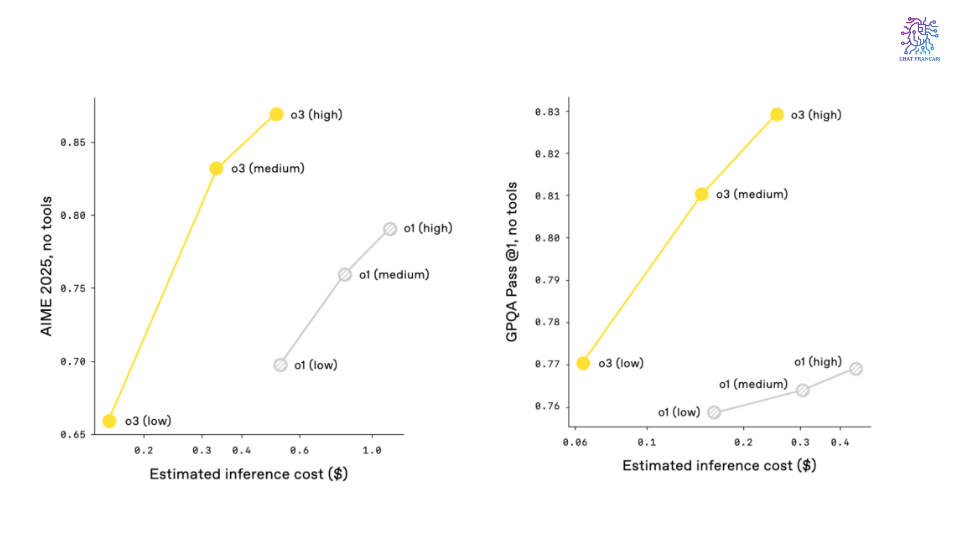

| Performance (STEM, code) | Très compétent ; premier pas vers le « raisonnement » appliqué. | Gains mesurables sur benchmarks math/coding dans les tests publics ; o3 montre des améliorations notables sur AIME / tests code. |

| Latence & coût | Plus économique qu’une délibération très lourde, mais coûteux en mode « pro » pour haut effort. | Tendance à consommer davantage de calcul pour les longues délibérations (variante o3-mini existante pour réduire coût/latence). |

| Disponibilité & usage | Déployé en 2024, intégré à certains produits/pro plans. | o3-mini a été mis en avant comme remplaçant d’o1-mini dans le sélecteur de modèles (meilleurs débits / taux d’appel pour Plus/Team). |

| Sécurité / transparence | Bonnes protections mais moins centré sur la délibération de sécurité explicite. | Conçu pour « réfléchir » aux règles de sécurité avant de répondre — réduction des sorties problématiques visée. |

Observations pratiques (quand choisir lequel)

-

Choisir o1 si vous avez besoin d’un modèle raisonnable, bien établi, et si vos workflows tolèrent une architecture déjà éprouvée (tests, intégrations existantes).

-

Choisir o3 (ou o3-mini) si votre priorité est : meilleures performances sur problèmes mathématiques/codage/science, meilleure intégration des contrôles de sécurité « pensés » par le modèle, ou si vous voulez profiter des optimisations latency/cost offertes par o3-mini dans ChatGPT.

Où o3 fait la différence (exemples concrets)

-

Mathématiques et concours : o3 montre des progrès significatifs sur des tâches multi-étapes comme celles présentes dans des concours mathématiques spécialisés — ses étapes de raisonnement intermédiaires aident à repérer et corriger des erreurs en cours de route. (Des benchmarks externes et rapports techniques confirment ces gains sur des ensembles de tests STEM.)

-

Codage et débogage : en décomposant logiquement un problème, o3 produit des suggestions de code plus argumentées et des diagnostics plus précis que les modèles qui n’utilisent pas ce type de délibération.

-

Analyse visuelle avancée : combinaison texte + image pour interpréter graphiques, plans ou captures d’écran dans un même flux de travail.

Transparence et sécurité : un point central

OpenAI a fait de la sécurité une priorité en entraînant o3 à « raisonner » sur des règles de sécurité (deliberative alignment). Le modèle évalue ses réponses vis-à-vis de politiques internes et peut rejeter ou reformuler une sortie problématique. Ces mécanismes visent à réduire les contenus dangereux ou trompeurs tout en conservant l’utilité pour l’utilisateur.

Coût, déploiement et limites pratiques

Penser plus prend plus de ressources : les capacités de délibération d’o3 entraînent une augmentation de la consommation de calcul par requête par rapport aux modèles rapides, ce qui se traduit logiquement par un coût d’utilisation plus élevé pour certaines tâches. Pour répondre à ce besoin, OpenAI propose des variantes (o3-mini, niveaux d’effort) afin que chaque utilisateur choisisse le meilleur compromis entre coût, latence et profondeur de raisonnement. Par ailleurs, l’intégration progressive d’o3 se fait en tenant compte des retours sur la montée en charge et des contraintes réglementaires.

Concurrence et positionnement

La sortie d’o3 s’inscrit dans une course plus large aux modèles « raisonneurs » : Google (Gemini) et d’autres acteurs publient eux aussi des architectures visant le même objectif — des réponses plus fiables et vérifiables. Face à cette dynamique, o3 se distingue par l’accent mis sur la délibération interne et la capacité multimodale, mais la compétition reste vive, notamment sur le plan de l’efficacité coût/performance.

Pour qui, et comment l’utiliser aujourd’hui ?

o3 est particulièrement adapté aux organisations et équipes qui ont besoin d’un raisonnement rigoureux (laboratoires, sociétés fintech, équipes R&D, product teams) ; o3-mini, lui, vise les développeurs et chercheurs qui cherchent un bon compromis pour des charges importantes. L’accès passe par l’API OpenAI et via les intégrations ChatGPT qui permettent d’expérimenter ces modèles dans des workflows réels.

En conclusion — une IA qui réfléchit, pas seulement qui répond

o3 marque une étape importante : l’IA cesse d’être un simple générateur de texte et devient un outil de raisonnement capable d’exposer (et parfois corriger) son propre cheminement. Cela améliore la confiance d’usage sur les tâches complexes, mais pose aussi des défis opérationnels (calcul, tarification, supervision). À mesure que ces modèles se déploient (et que des variantes économiques se généralisent), ils pourraient profondément transformer la façon dont entreprises et chercheurs délèguent des tâches intellectuelles répétitives à l’IA.