ChatGPT-4o, développé par OpenAI, représente un bond significatif dans le domaine de l’intelligence artificielle. Grâce à ses capacités multimodales avancées, ce modèle peut traiter et générer du texte, de l’audio, et des contenus visuels de manière fluide. Cet article explore les fonctionnalités clés, les cas d’utilisation potentiels et l’importance de ce modèle innovant.

Présentation de ChatGPT-4o

ChatGPT-4o est la dernière version des modèles de langage d’OpenAI. Il a été conçu pour améliorer les interactions utilisateur grâce à une meilleure compréhension et génération de contenus sur plusieurs formats. Le “o” dans GPT-4o signifie “omni”, reflétant sa capacité à gérer divers types d’entrées—texte, audio, images et vidéo—dans un cadre unique. Cette intégration représente une avancée significative par rapport à ses prédécesseurs tels que GPT-3 et GPT-4, qui nécessitaient des systèmes distincts pour différents types de contenus.

Fonctions principales et innovations

Voici ce que GPT-4o apporte de nouveau :

-

Traitement multimodal unifié : GPT-4o accepte des entrées combinées — texte, image, audio, vidéo — et produit des sorties dans ces mêmes formats. Cela élimine le besoin d’enchaîner plusieurs modèles distincts pour transcrire, traiter et restituer.

-

Latence audio très réduite : il peut répondre à une entrée audio en aussi peu que 232 millisecondes, avec une moyenne d’environ 320 ms — ce qui rapproche l’interaction du temps de réponse d’une conversation humaine normale.

-

Amélioration des langues non-anglaises : GPT-4o surpasse GPT-4 Turbo sur la compréhension et la génération dans plusieurs langues autres que l’anglais, ce qui améliore le vécu des utilisateurs internationaux.

-

Coût et vitesse optimisés : comparé à GPT-4 Turbo, GPT-4o est plus rapide dans beaucoup de tâches, et pour l’API, plus abordable.

Cas d’usage pratiques

Grâce à ses capacités, GPT-4o permet de :

-

Avoir des conversations vocales fluides, avec reconnaissance du ton, ambiance sonore, bruit de fond — des éléments que les anciens systèmes traitaient moins bien.

-

Utiliser des images pour enrichir les prompts — par exemple un schéma technique ou une photo d’un panneau multilingue pour demander une traduction + explications culturelles.

-

Travailler plus efficacement pour les utilisateurs dans plusieurs langues, avec moins de latence, pour des applications d’assistance, de support client, d’apprentissage linguistique ou de collaboration créative.

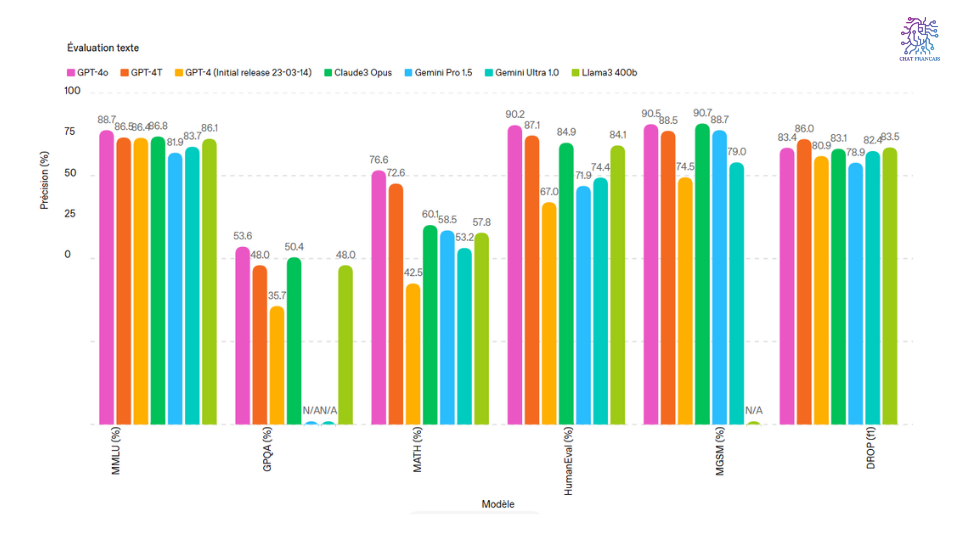

Comparaison avec les modèles précédents

| Modèle | Modalités acceptées | Latence audio / vocales | Coût relatif / efficacité |

|---|---|---|---|

| GPT-4 | Texte + images, mais mode audio vocal indirect via pipelines externes | ~5,4 secondes pour la conversion via pipeline voix → texte → voix. | Coût plus élevé pour interprétation vocale ; moins efficace pour usage multilingue non anglais. |

| GPT-4o | Texte, audio, image, vidéo intégrés dans un seul modèle | ~232-320 ms pour les entrées audio, soit un grand progrès. | Meilleure efficacité, réduction des coûts d’API, performances globales améliorées, surtout pour les tâches multimodales. |

Limites et points à surveiller

Même si GPT-4o est très avancé, il reste des zones à améliorer :

-

Certaines tâches très spécialisées ou techniques (schémas très précis, données scientifiques complexes) montrent que le modèle ne rivalise pas encore avec des outils experts.

-

Bien que le modèle soit plus rapide et moins coûteux que certains anciens pipelines, le traitement multimodal reste exigeant en ressources générales : réseau, matériel, et capacité de traitement.

-

En termes de disponibilité, certaines fonctions avancées (ex : génération vidéo en temps réel) ou langues spécifiques peuvent être déployées progressivement selon les régions.

Déploiement et accès

-

GPT-4o est déjà disponible dans ChatGPT pour plusieurs utilisateurs, y compris des utilisateurs gratuits dans certains cas, avec des fonctions moins restreintes que par le passé.

-

L’API “Realtime” permet d’utiliser GPT-4o pour entrées audio / texte en temps réel, avec des préversions dans certaines régions.

-

OpenAI a également publié des modèles “speech-to-text” / “audio preview” et des capacités de génération audio intégrées pour certains usages.

En conclusion

ChatGPT-4o ouvre la voie à des interactions plus naturelles avec l’IA : voix, vision, texte ne sont plus des silos séparés mais des modalités manipulées de concert. Pour les utilisateurs à la recherche de fluidité, de rapidité et d’intégration multimodale — que ce soit pour l’apprentissage des langues, le support client, la création ou simplement pour explorer — GPT-4o représente une évolution remarquable. Reste à surveiller son évolution sur les cas très spécialisés et les aspects de coût / efficacité, mais l’orientation est très claire : une IA plus proche de la communication humaine.